【导读】自特斯拉FSD V12率先将端到端大模型引入量产车以来,"规则驱动"向"数据驱动"的范式转移已成为行业共识——动作是否流畅、能否应对长尾场景、决策是否拟人化,取代了传统的功能清单,成为衡量智能驾驶体验的新标尺。在这场由方法论革新引发的浪潮中,蔚来经历了从规则构建到数据驱动的艰难转身,如今又以"世界模型+闭环强化学习"的全新架构重新出发。当技术路线的迷雾逐渐散去,蔚来新版NOA能否凭借这套端到端强化学习体系,在复杂的中国城市场景中实现真正的"拟人化"突破,重回行业第一梯队?

Part 1、蔚来的辅助驾驶的转型

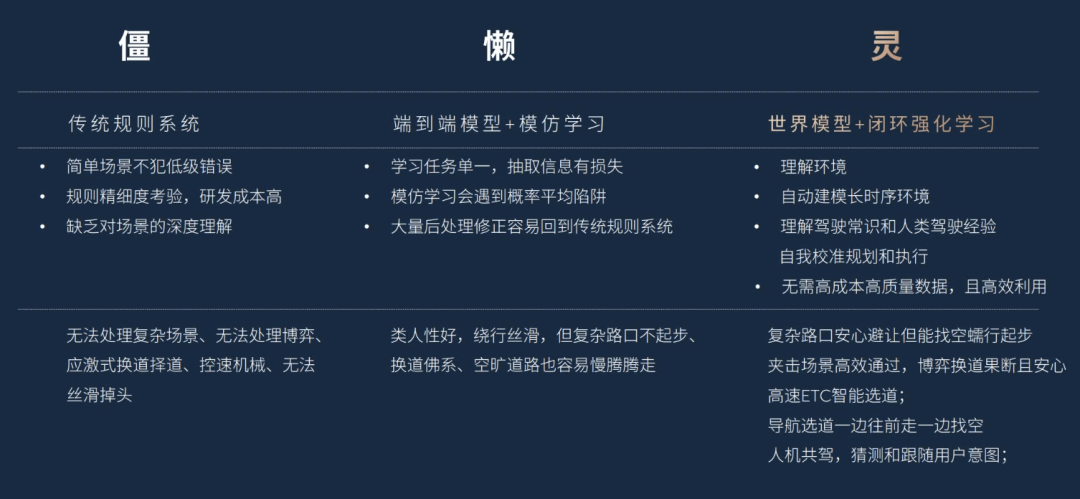

在中国智能驾驶的迭代中,特斯拉提出的端到端一个拐点,在出现了这个技术变化之后,城市NOA中拟人化变成了非常重要的评价点,规则味比较重,是落后的标志。

体验上主要是动作机械、加减速转向不流畅、卡顿,无法应对各种Corner case, FSD V12、V13 V14 的一路发展,在方法论上特斯拉是一路牵引整个行业的发展。

在蔚来的第一代车型,是围绕规则来构建的辅助驾驶,确定变道距离、确定的加减速逻辑、确定的安全边界。在中国复杂的城市场景复杂度下并不完善。

从规则开始,蔚来花了很多时间来切换技术路线。转向数据驱动过程中,用模型把规则“压缩”进参数里,让系统通过学习大量真实驾驶数据,自己学会如何变道、择道。

数据驱动的问题是,同一个场景下,人类的行为并不一致。在道路上,人的习惯和交通流量都会影响决策,从结果来看,能看到不同的驾驶员在不同的位置换道,模型学到的是一种“折中选择”,为了安全往往选择保守跟随,或者说要真正实现“高效、主动通行”,伴随着不少的小事故。

为了平衡风险,引入更强的地图和路径引导、采集专家驾驶数据并减少行为差异,或者加回一部分规则逻辑。这些都是中国在这段时间走过的路。

Part 2、蔚来新版的NOA

蔚来世界模型在2026年的目标是回到行业的数一数二的位置。方法是对智能辅助驾驶全研发迭代方法进行调整,引入世界模型 + 闭环强化学习的模式。

这也是以端到端系统为基础,核心分为三步:

基础行为习得:通过学习海量人类驾驶行为,让模型形成驾驶答题本,标记各类场景下的行为概率,习得驾驶基本肌肉记忆;

环境深度理解:模型从当前时刻出发,预测自身下一步多种动作,并推演不同动作对周围环境的影响,及环境变化对自身行为的反作用,实现长达数分钟的长时序思考,这是核心运行机制;

闭环强化校准:在虚拟「驾驶考场」中,通过数上亿轮专业场景训练和评估反馈,让模型精准理解「好行为与差行为的区别」,基于驾驶常识和人类经验校准行为「答题本」,这一过程即为闭环强化学习。

这里要回答几个关键问题,强化学习到底解决了什么问题?这是给结果打分,让模型自己学,模型输出行为后,系统会根据结果给予正向或负向反馈,让模型在反复尝试中学会什么是“更优解”,过程本身就是一种自我校正。

在实际训练中,通过奖励评估机制直接给行为打分;利用真实人类行为反馈,反推出奖励信号, 模型在其中会经历自监督学习,逐步形成稳定的决策偏好。

举例来说先构建一个仿真环境,在其中设定一条“目标线”,车辆如果顺利完成左转并线,就得到奖励;完成得越快、越平顺,奖励越高。

在此基础上,只保留少量必要的约束,比如压实线会被扣分,但不再写复杂规则。在哪个位置变道、如何跨越三条车道、怎样兼顾效率与安全,全部交给模型在仿真环境中自行探索。

在这样的基础上不需要为每一个特殊路口单独采集数据。只要仿真环境中构建出“相似结构”的场景,模型就能迁移能力,避免了为成百上千个复杂路口重复采数据的低效过程。目标简单、约束少,让模型自己找路径。

规则一旦极简,反而更稳定、更通用。

Part 3、实际的体验

在我们的实际体验中,换道策略、导航选道,在道路中的刹车控制都有很大的改善。

偏航和复杂路口,是需要“提前判断”的场景,NOA的系统在快到路口才反应一般感受会很差或者就错了(要么压实线要么错了),需要在更早的阶段就意识到,模型会提前接收到“未来惩罚”,从而主动调整决策。

实际上,在拟人化抉择上,比如判断安心感充足时果断切入,不鲁莽挤压旁车;目标车道拥堵时,缓慢前行并持续寻找变道空隙;通过蠕行寻找通行空隙,这些行为都是挺大的改善。

结论

蔚来的探索揭示了一个核心趋势:智能驾驶的下半场竞争,本质上是"学习效率"与"泛化能力"的较量。世界模型赋予系统长时序推演能力,让车辆能够"预见"而非"反应";闭环强化学习则通过虚拟考场中的亿级轮次训练,使模型在极少规则约束下自主寻优,实现从"学会开车"到"开好车"的跃迁。实际体验中换道策略的果断、复杂路口的提前预判、拥堵场景下的蠕行寻隙,都是这一技术路线落地的直观印证。